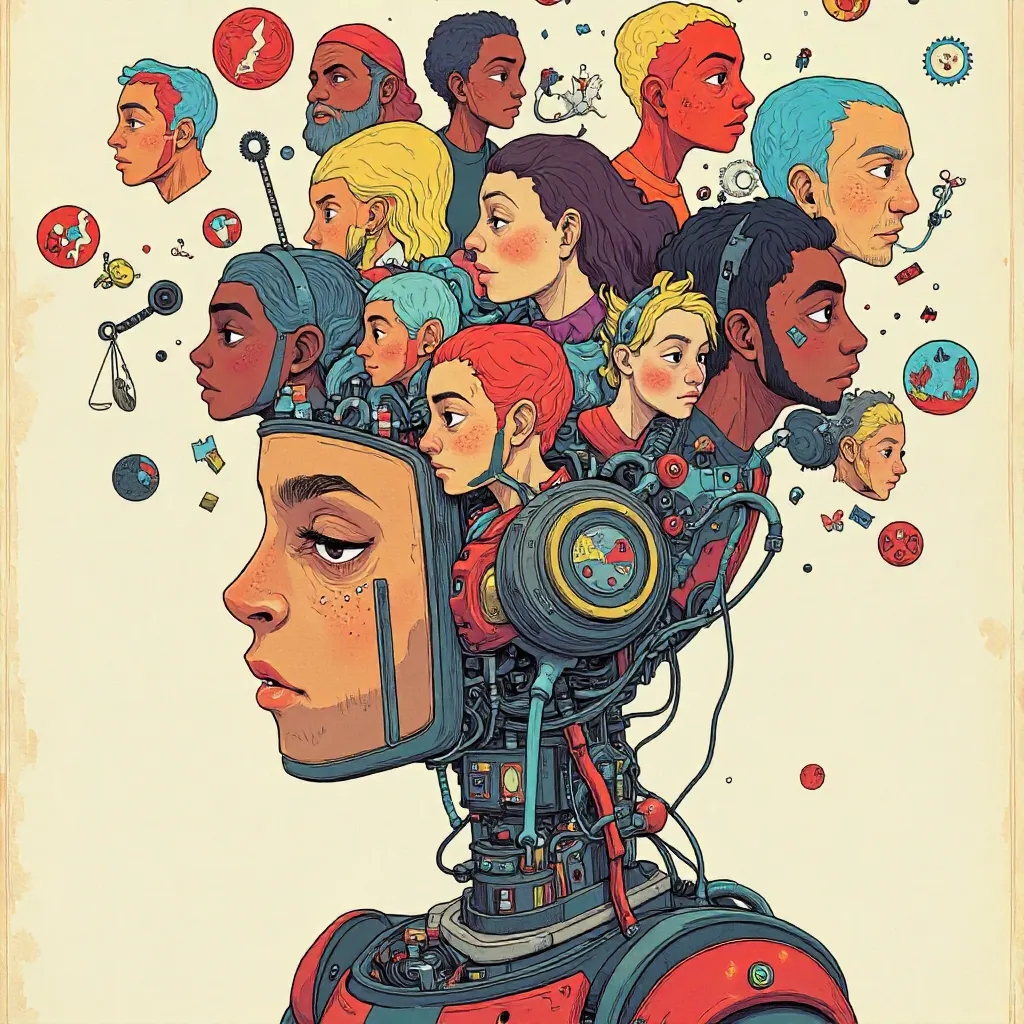

Code & Vorurteil. Über Künstliche Intelligenz, Rassismus und Antisemitismus

„Code & Vorurteil. Über Künstliche Intelligenz, Rassismus und Antisemitismus“ von Deborah Schnabel, Eva Berendsen, Leo Fischer und Marie-Sophie Adeoso untersucht, wie Vorurteile und Diskriminierungen in KI-Systeme eingebettet werden. Das Buch analysiert historische und gesellschaftliche Wurzeln von Rassismus und Antisemitismus und zeigt konkrete Beispiele, wie Algorithmen diskriminierende Muster reproduzieren. Es diskutiert Strategien zur Bekämpfung von Bias in technischen Systemen und betont die Notwendigkeit interdisziplinärer Zusammenarbeit.

„Code & Vorurteil. Über Künstliche Intelligenz, Rassismus und Antisemitismus“ von Deborah Schnabel, Eva Berendsen, Leo Fischer und Marie-Sophie Adeoso bietet eine fundierte Auseinandersetzung mit der Problematik der Vorurteile in der Entwicklung und Anwendung von KI-Technologien. Die Autorinnen und Autoren erläutern, dass Algorithmen und Datensätze nicht neutral sind, sondern gesellschaftliche Vorurteile widerspiegeln, die historische Ungleichheiten und Diskriminierungen verstärken. Sie führen detaillierte Fallstudien an, in denen KI-Systeme Rassismus und Antisemitismus reproduziert haben, und zeigen, wie fehlerhafte oder voreingenommene Daten zu diskriminierenden Entscheidungen führen können.

Das Buch beginnt mit einer historischen Kontextualisierung, die erklärt, wie rassistische und antisemitische Denkweisen in Gesellschaften entstanden und institutionalisierte Strukturen prägten. Diese historischen Muster sind oft in den Trainingsdaten der KI verborgen. Konkret beschreiben die AutorInnen, wie beispielsweise Gesichtserkennungstechnologien bestimmte ethnische Gruppen falsch identifizieren oder wie Bewerberauswahlalgorithmen Menschen aufgrund ihrer Herkunft benachteiligen, weil sie auf verzerrten Datensätzen basieren. Solche Beispiele verdeutlichen, dass technologische Neutralität ein Mythos ist und dass Technologie stets in soziale Kontexte eingebettet ist.

Weiterhin diskutieren Schnabel, Berendsen, Fischer und Adeoso die Mechanismen, durch die Vorurteile in den Code gelangen. Sie erklären, dass Entwicklerinnen unbeabsichtigt Vorurteile einbauen können, wenn sie nicht auf Diversität achten oder wenn sie Annahmen über Benutzerinnen treffen, die nicht der Realität entsprechen. Die Autoren zeigen auf, wie stereotype Annahmen und mangelnde Reflexion über den eigenen kulturellen Hintergrund technische Systeme beeinflussen können.

Das Buch präsentiert auch Lösungsansätze zur Minderung von Bias in KI. Die AutorInnen empfehlen die Entwicklung diverser, repräsentativer Datensätze, interdisziplinäre Teams bei der KI-Entwicklung und transparente, überprüfbare Algorithmen. Ein konkreter Ansatz ist die Implementierung von Fairness-Algorithmen, die systematisch Diskriminierung erkennen und korrigieren sollen. Sie diskutieren Projekte, bei denen durch offene Audits und die Zusammenarbeit mit betroffenen Gemeinschaften verbesserte, gerechtere KI-Systeme entwickelt wurden.

Die Schlussfolgerungen betonen die Notwendigkeit eines bewussten, kritischen Umgangs mit KI und die Einbindung ethischer Überlegungen von Anfang an. Die AutorInnen rufen dazu auf, Bildung und Sensibilisierung über algorithmische Vorurteile zu fördern und gesetzliche Rahmenbedingungen zu schaffen, die faire und inklusive Technologien gewährleisten. Sie argumentieren, dass die Bekämpfung von Rassismus und Antisemitismus in KI ein fortlaufender interdisziplinärer Prozess ist, der technisches Wissen mit sozialer Verantwortung verknüpfen muss.

QUELLE / ISBN - 9783957325891

--> Deutsche Nationalbibliothek--> WorldCat

--> Open Libary